قبل از اینکه به بهینه سازی فایل Robots.txt بپردازید باید ابتدا بدانید که این فایل چیست و چه کاربردی دارد؟

فایل Robots.txt چیست ؟

Robots.txt یک فایل متنی است که صاحبان وب سایت ها می توانند با ایجاد آن به رباتهای گوگل بفهمانند که چگونه می توانند صفحات سایت را خزش و ایندکس کنند. این فایل معمولا در پوشه اصلی وب سایت شما ذخیره می شود. به طور پیش فرض فایل robots.txt به این شکل است:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

شما می توانید چندین دستورالعمل در این فایل وارد کنید تا URL های خاصی را برای ایندکس مجاز یا مسدود کنید و می توانید چند نقشه سایت اضافه کنید. در اینجا یک نمونه فایل robots.txt مشاهده می کنید:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

در مثال فوق ، ما ابتدا با دستور * :User-Agent اعلام کردیم که تمامی ربات های موتور های جستجو می توانند این دستوالعمل ها را رعایت کنند و این دستورات شامل تمامی ربات ها خواهد شد. با دستور :Allow به ربات های گوگل اجازه داده ایم که تمام فایل ها را در مسیر /wp-content/uploads/ خزش و ایندکس کنند. با دستور :Disallow به رباتهای تمام موتورهای جستجو دستور دادیم مسیرهای /wp-content/plugins/ و /wp-admin/ را خزش و ایندکس نکنند. این دو مسیر به ترتیب مربوط به پلاگین ها و مدیریت سایت وردپرس می باشد و نیاز به ایندکس هم ندارند. و در نهایت با دستور :Sitemap آدرس نقشه xml سایت را به ربات ها نشان داده ایم.

فایل robots.txt چه مزایایی دارد؟

- این فایل به خوبی می تواند از ایندکس شدن صفحات و دایرکتوری های حساس مانند ادمین، صفحات ورود، سبدهای تجارت الکترونیک و موارد مشابه جلوگیری کند.

- به طور صحیح باعث جلوگیری از اضافه بار سرور می شود. در نتیجه فرآیند پشتیبانی سایت سهل و آسان خواهد شد.

- با این فایل به راحتی میتوانید با ایجاد محدودیت بخش های خاصی از سایت خود را از لحاظ دسترسی مسدود کنید.

- از به نمایش درآمدن محتواهای تکراری در فهرست نتایج گوگل جلوگیری می کند.

- موقعیت sitemap را برای ربات ها مشخص می کند و باعث تسهیل در فرایند ایندکس می شود.

- شما میتوانید با این فایل صفحات بی اهمیت را مسدود کنید. در نتیجه بودجه مرتبط با خزیدن سایت افزایش می یابد. به بیان دیگر Googlebot می تواند سهم یا بودجه خزیدن خود را برای صفحات بسیار مهم صرف کند.

بهترین تکنیک ها برای Robots.txt در جهت بهبود سئو

- مسدود سازی پوشه های CSS یا JS به هیچ عنوان توصیه نمی شود. چرا که صفحات سایت در اغلب موارد ممکن است به این دو پوشه نیاز داشته باشد تا بتواند یک عملکرد مناسبی ارائه دهد.

- از فایل txt به منظور جلوگیری از دسترسی به اطلاعات حساس استفاده نکنید. اگر به هر نحوی تمایل دارید که یک صفحه یا دایرکتوری خود را از فهرست نتایج جستجو حذف یا مسدود کنید می توانید از تکنیک های دیگری از قبیل رمزگذاری یا تکنیک های مرتبط با noindex استفاده کنید.

- حتماً فایل مذکور را تست کنید. اطمینان حاصل کنید بخش هایی که تمایل دارید در فهرست موتورهای جستجو ظاهر شوند مسدود نکرده باشید.

- در وب سایت وردپرسی خود نیاز نیست که دسترسی به فولدرهای wp-admin و wp-include را مسدود کنید. چرا که وردپرس این قابلیت را دارد که در به کارگیری از متا تگ ربات ها عملکرد مناسبی از خود نشان دهد.

آیا ما برای سایت وردپرس خود به فایل Robots.txt نیاز داریم؟

اگر این فایل را ایجاد نکردید، همچنان موتورهای جستجو سایت شما را خزش و ایندکس می کنند. با این حال، شما بدون داشتن فایل robots.txt نمی توانید به موتورهای جستجو بگویید که کدام صفحات و مسیرهای سایت را ایندکس نکنند. اگر سایتتان را تازه راه اندازی کردید و صفحات زیادی ندارد داشتن این فایل تاثیر زیادی بر سئو وب سایت نخواهد گذاشت. با این وجود وقتی وب سایت شما رشد و توسعه پیدا می کند و صفحات آن بیشتر می شود پس قطعا به وجود فایل robots.txt برای کنترل بهتر در نحوه خزیدن و ایندکس صفحات سایت خود نیاز خواهید داشت.

دلیل وجود این فایل این است که : ربات های موتورهای جستجو برای هر وب سایت سهمیه خزیدن و ایندکس دارند.

این بدان معنی است که آنها تعداد مشخص و محدودی از صفحات را در یک جلسه، خزش و ایندکس می کنند. اگر آنها در آن جلسه خزیدن در تمام صفحات سایت شما را به پایان نرسانند، دوباره برمی گردند و در جلسه بعدی خزیدن را از سر می گیرند. پس مدیریت و بهینه سازی فایل robots.txt می تواند سرعت خزش و ایندکس صفحات سایت شما را افزایش دهد. با مسدود کردن خزش ربات های گوگل در صفحات و مسیرهای غیر ضروری مانند پلاگین ها ، تم ها ، مدیریت وردپرس می توانید این مشکل را برطرف کنید. اینکار به موتورهای جستجو کمک می کند تا در هر جلسه صفحات بیشتری از سایت شما را جستجو و خزش کنند و با سرعت بیشتر بتوانند صفحات ضروری را ایندکس کنند.

دلیل دیگر استفاده از فایل robots.txt زمانی است که می خواهید رباتهای گوگل را از ایندکس یک مقاله یا صفحه خاصی از وب سایت خود مسدود کنید. این امن ترین و مطمئن ترین راه برای مخفی کردن مطالب سایت از دید عموم کاربران نیست، اما به شما کمک می کند تا از نمایش آنها در نتایج جستجو جلوگیری کنید.

چگونه یک فایل Robots.txt بهینه شده و ایده آل بسازیم؟

بسیاری از سایت های بزرگ و معروف از یک فایل robots.txt بسیار ساده استفاده می کنند. محتوای این فایل بسته به نیاز هر سایتی ممکن است متفاوت باشد:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

نمونه فایل robots.txt فوق به همه ربات ها اجازه می دهد تا تمام مطالب سایت از جمله تمام نوشته ها و برگه ها را ایندکس کنند.

اگر سایت وردپرسی دارید، دستورات زیر را در فایل robots.txt توصیه می کنیم:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این امر به ربات های موتور جستجو می گوید تا تمام تصاویر و پرونده های وردپرس را خزش و ایندکس کنند و ربات های جستجو را از خزش فایل های افزونه های وردپرس، بخش مدیریت وردپرس، فایل readme وردپرس و پیوندهای وابسته را مسدود می کند. با افزودن نقشه xml سایت به فایل robots.txt نیز می توانید جستجوی همه صفحات سایت خود را برای ربات های گوگل آسان کنید.

حال که دانستید یک فایل ایده آل و بهینه شده فایل robots.txt به چه شکل است، بیایید نگاهی به نحوه ایجاد یک این فایل در وردپرس بیندازیم.

چگونه یک فایل Robots.txt در سایت وردپرس ایجاد کنیم؟

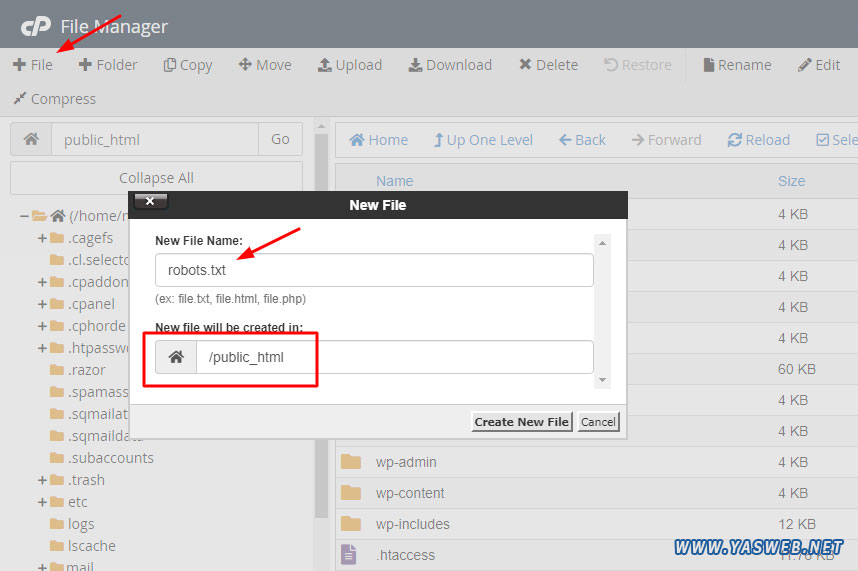

برای ساخت این فایل وارد هاست خود شوید و در مسیر public_html با استفاده از گزینه File + فایلی با نام robots.txt بسازید و فایل موجود را در حالت ویرایش باز کنید. (حتما قبل از ساخت این فایل مطمئن شوید از قبل این فایل درون هاست شما موجود نباشد.)

فایل robots.txt یک فایل ساده متنی با فرمت txt. می باشد یعنی می توانید این فایل را در کامپیوتر خود ایجاد کنید و کدهای مربوطه را در آن قرار داده و سپس در مسیر روت هاست خود (public_html) آپلود کنید.

چگونه فایل Robots.txt سایت خود را تست کنیم؟

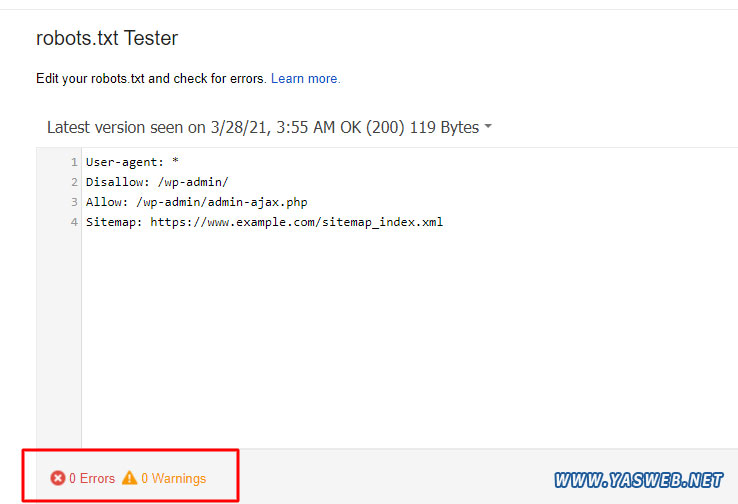

هنگامی که فایل robots.txt خود را ایجاد کردید، همیشه بهتر است آن را با استفاده از یک ابزار تستر robots.txt آزمایش کنید. ابزارهای آنلاین زیادی برای تست robots.txt وجود دارد، اما توصیه می کنیم با استفاده از ابزار موجود در سرچ کنسول گوگل تست کنید.

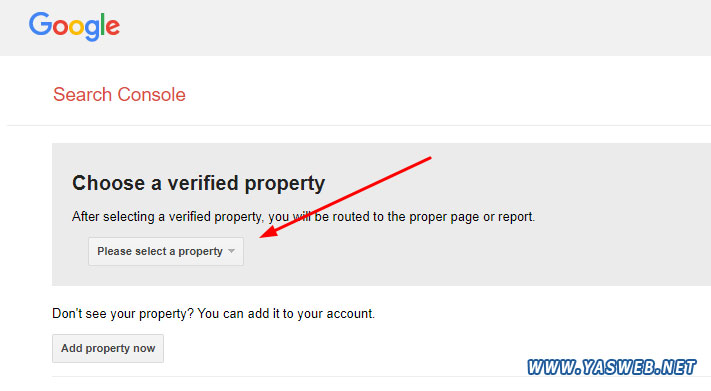

ابتدا باید وب سایت خود را به Google Search Console معرفی کنید. اگر هنوز این کار را انجام نداده اید، به راهنمای ما در مورد نحوه افزودن سایت وردپرس خود به سرچ کنسول گوگل مراجعه کنید.

سپس ، می توانید از ابزار Google Search Console Robots Testing Tool استفاده کنید. در صفحه موجود می توانید سایت خود را از منوی کشویی انتخاب کنید.

این ابزار به طور خودکار فایل robots.txt وب سایت شما را بررسی می کند و در صورت یافتن خطاها و هشدارها، به شما نشان می دهد.

سخن آخر

هدف از بهینه سازی فایل robots.txt جلوگیری از خزیدن ربات های موتور جستجو در صفحاتی است که در دسترس عموم کاربران نیست. به عنوان مثال، صفحات موجود در پوشه wp-plugins یا صفحات موجود در wp-admin اصلا لازم نیست توسط ربات ها خزش شوند.

یک تفکر اشتباه بین متخصصان سئو این است که مسدود کردن دسته بندی وردپرس ، برچسب ها و صفحات بایگانی ها سرعت خزیدن را بهبود می بخشد و منجر به ایندکس سریعتر و رتبه بندی بالاتر در گوگل می شود. این تفکر درست نیست و برخلاف دستورالعمل های گوگل می باشد.

توصیه می کنیم برای ایجاد یک فایل robots.txt بهینه شده و ایده آل برای وب سایت وردپرس خود از نمونه های فوق استفاده کنید. امیدواریم این مقاله به شما کمک کند تا یاد بگیرید چگونه فایل robots.txt وردپرس خود را برای سئو بهینه سازی کنید.

رفع تمام مشکلات سایت وردپرسی شما با خدمات پشتیبانی و توسعه سایت

اگر نیاز به مشاوره و رفع مشکلات سایت وردپرسی خود داشتید می توانید با کارشناسان یاس وب تماس گرفته و از خدمات سئو و بهینه سازی و خدمات پشتیبانی سایت استفاده کنید. تیم ما تمامی موارد و مشکلات سایت شما را بررسی کرده و راه حل هایی در جهت پیشرفت سئو و توسعه سایت شما ارائه خواهد داد.

بدون دیدگاه